网页爬虫:通过网络爬虫程序定期访问互联网的网页,抓取网页上的内容,包括文本、图片、视频等,并将这些信息存储在搜索引擎的数据库中。

搜索引擎利用什么技术

1. 网页爬虫:通过网络爬虫程序定期访问互联网的网页,抓取网页上的内容,包括文本、图片、视频等,并将这些信息存储在搜索引擎的数据库中。

2. 索引技术:搜索引擎通过对抓取的网页内容进行索引,建立词汇表和文档倒排索引,将网页中的关键词和网页地址进行映射,以便用户搜索时快速找到相关网页。

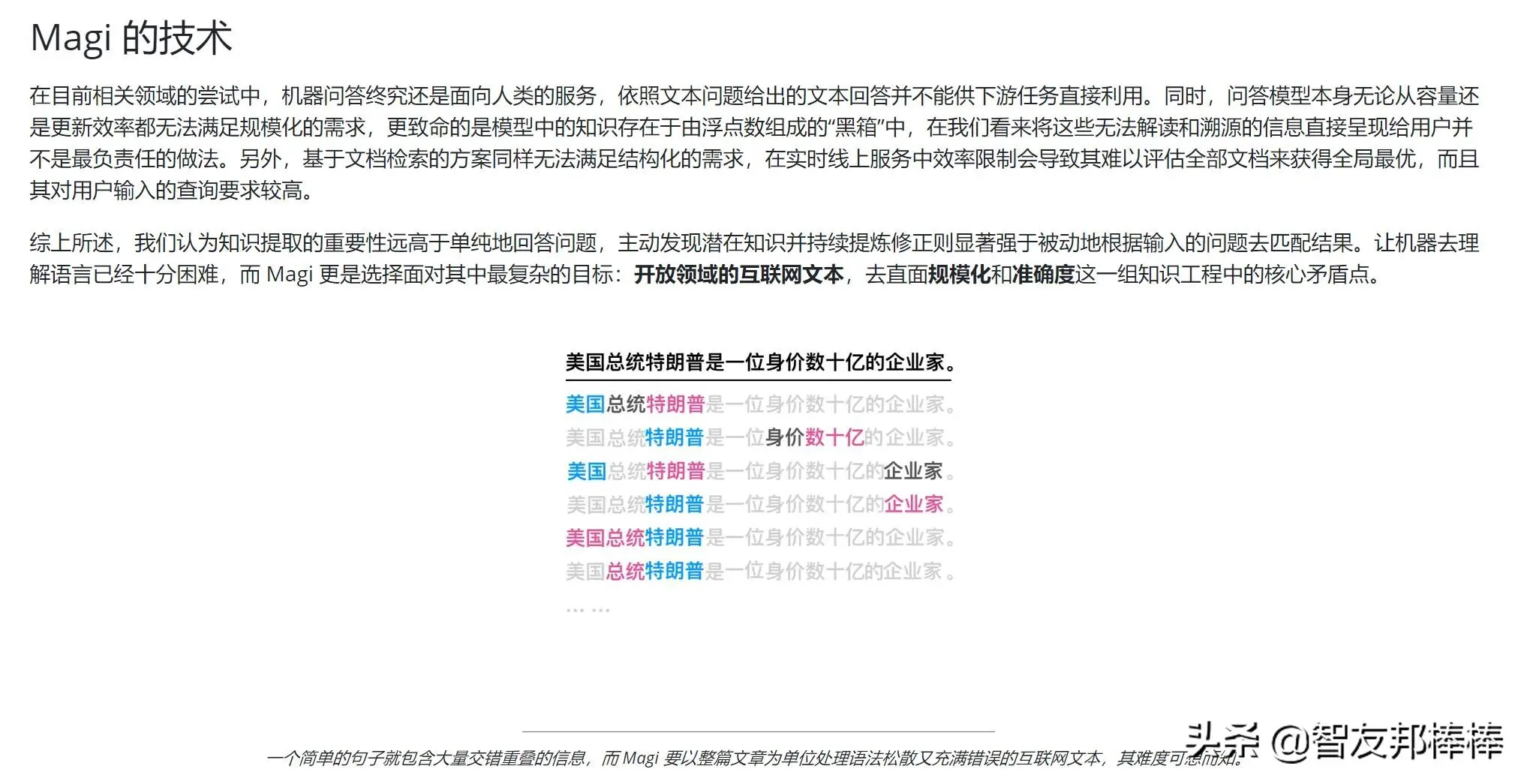

3. 自然语言处理技术:搜索引擎利用自然语言处理技术识别用户的搜索意图,将搜索关键词转化为特定的查询语句,并结合索引技术进行快速匹配。

4. 机器学习技术:搜索引擎利用机器学习技术对用户搜索行为进行分析和学习,不断优化搜索结果的排序和相关性,提高搜索结果的质量。

5. 大数据技术:搜索引擎利用大数据技术对用户搜索数据进行分析和挖掘,以了解用户的兴趣和需求,从而提供更加个性化的搜索结果。

搜索引擎技术采用什么

搜索引擎技术采用什么随着互联网的普及和快速发展,搜索引擎已经成为了人们获取信息的主要途径之一。那么,为了让我们更好地了解搜索引擎技术,本文将从以下三个方面来介绍搜索引擎技术采用的内容。

一、搜索引擎技术采用的算法

搜索引擎技术中最关键的一个方面就是算法,也是搜索引擎被称作“者”的原因之一。搜索引擎的算法可以分为两类:抓取算法和排名算法。抓取算法决定了搜索引擎如何获取和处理网站信息,而排名算法则决定了搜索引擎如何排列显示搜索结果。

对于抓取算法,搜索引擎会通过爬虫程序到网站上抓取页面,然后将收集到的数据存储在搜索引擎的数据库中。排名算法则包括了多种技术,例如PageRank、TF-IDF等等。这些算法都是为了保证搜索结果的质量和准确性。

二、搜索引擎技术采用的计算机语言和数据库

搜索引擎技术采用的计算机语言主要有两种,一种是客户端语言,另一种则是服务器端语言。客户端语言主要是用来实现搜索引擎的前端界面,例如HTML、CSS、JavaScript等。服务器端语言则主要是用来处理搜索引擎的业务逻辑,例如PHP、Java、Python等。

搜索引擎也需要使用数据库来存储大量的数据。常见的数据库包括MySQL、Oracle、SQL Server等。搜索引擎的数据库也需要使用一些技术来对数据进行索引和优化,使得搜索结果的速度更快、更准确。

三、搜索引擎技术采用的人工智能技术

人工智能技术也成为了搜索引擎技术中的重要部分。搜索引擎可以通过机器学习等技术来不断优化和改进搜索结果的质量。例如,在用户搜索时,搜索引擎可以通过分析用户的搜索行为和历史数据,推荐更加准确的搜索结果。另外,搜索引擎还可以通过自然语言处理技术,识别和理解搜索的意图,从而更好地满足用户的需求。

总体来说,搜索引擎技术采用了多种技术和算法来实现其核心功能。随着技术的不断发展,搜索引擎的功能也将不断增强和完善。

搜索引擎依赖什么技术

搜索引擎依赖什么技术随着互联网的发展,搜索引擎越来越成为人们获取信息的主要方式。另外还有,搜索引擎的出现并不是一蹴而就的,它需要依赖各种技术的支持,才能实现它的功能。那么,究竟搜索引擎依赖什么技术呢第一,搜索引擎需要一套强大的爬虫技术,也称为蜘蛛技术。爬虫技术是指搜索引擎通过自动化程序,对互联网上的网页进行抓取、索引和处理,以便后续搜索引擎对用户的查询进行匹配。爬虫技术的核心是对爬虫算法的优化,这需要考虑到各种因素,如爬虫速度、抓取深度、抓取精度等等。

第二,搜索引擎需要一个高效的搜索算法,以便根据用户的查询快速获取相关的搜索结果。搜索算法经常会用到计算机科学中的各种算法,如排序算法、数据结构算法等等,而这些算法的优化和组合将直接影响搜索引擎的性能。

第三,搜索引擎还需要强大的分词技术,也称为语义分析技术。分词技术是指将用户的查询分解成单词或短语,并对这些单词进行分类、整理、去重等操作,以便搜索引擎更好地理解用户的搜索意图。分词技术的另一个重要方面是语义分析技术,它可以识别用户查询中的语言规则和语义关系,并根据这些规则和关系对搜索结果进行排序。

第四,搜索引擎还需要一个可靠的数据库和服务器架构来存储和管理搜索结果。这个数据库需要具有高速、高容量和高可靠性的特点,以便保证搜索引擎的性能和可用性。第一,搜索引擎还需要一台强大的服务器来承载所有这些信息和运算,以便高效地提供服务。

在总体上,搜索引擎需要依赖多个关键技术的支持,才能实现使用者友好的搜索体验。这些技术包括强大的爬虫技术、高效的搜索算法、专业的分词技术以及可靠的数据库和服务器架构。只有这些技术的集成,才能满足人们对于搜索引擎的高要求。

搜索引擎采用的什么技术

搜索引擎采用的技术包括:

1.爬虫技术:利用爬虫程序自动扫描互联网,收集网页信息,将其存储在搜索引擎的数据库中。

2.索引技术:将爬虫程序收集到的网页内容进行分析和分类,建立关键字索引,便于用户查询。

3.自然语言处理技术:对用户的查询输入进行语义分析和理解,从而为其提供最相关的搜索结果。

4.排名算法技术:利用机器学习、人工智能等技术,根据网页质量、链接数量等多个因素,对搜索结果进行排序,提高搜索引擎的准确性和效率。

5.分布式计算技术:利用分布式计算技术提高搜索引擎的处理能力和可靠性,确保用户能够快速获得所需的信息。

评论列表 (0)