Chatbot是当前人工智能中比较热门的领域,它能够与用户进行自然的语言交互。而Chatbot的实现离不开数据,在机器学习中,数据是训练模型的重要基础。对于Chatbot来说,需要多少数据才能够训练出一个高质量的模型呢?本文将从不同的角度来探讨这个问题。

chatgpt训练需要多少数据

Chatbot是当前人工智能中比较热门的领域,它能够与用户进行自然的语言交互。而Chatbot的实现离不开数据,在机器学习中,数据是训练模型的重要基础。对于Chatbot来说,需要多少数据才能够训练出一个高质量的模型呢?本文将从不同的角度来探讨这个问题。

数据量的影响

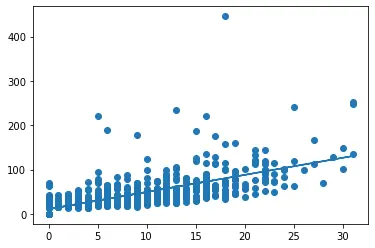

首先来看数据量对Chatbot性能的影响。数据量通常与模型的性能成正比。也就是说,数据量越多,训练出的模型性能越好。这是因为足够的数据可以提供足够的范例,使得模型可以更好地理解和用户的需求和意图。相反,如果数据量不足,则会导致模型过度拟合,降低模型的泛化能力和稳定性。

需要注意的是,数据量也受到模型的类型和复杂度的影响。如果模型非常简单,那么数据量要求就比较低,几千条数据就足够训练出一个基本的模型。需要注意的是,如果模型非常复杂,比如使用了深度学习或强化学习等技术,数据量要求就会增加。在这种情况下,需要成千上万的数据才能够训练出一个高质量的模型。

数据质量的影响

除了数据量,数据质量也非常重要。数据质量指的是数据的准确性、完整性和多样性等方面。如果数据不准确或缺失关键信息,那么训练出的模型就会出现偏差或错误。另外,如果数据过于单一或重复,那么模型就会缺乏泛化能力,无法处理不同的场景和情况。

因此,在选择数据时,必须确保数据的质量。最好选择多样性和真实性较高的数据集,这样才能够训练出一个具有良好泛化能力的模型。

结论

概括一下的话,Chatbot训练所需的数据量取决于许多因素,如模型类型、复杂度和数据质量等。一般来说,至少需要几千条真实和多样的数据才能够训练出一个基本的模型。如果希望获得更好的性能,需要更多的数据。首先呢,必须注意选择高质量的数据集,以确保训练出的模型具有良好的泛化能力和稳定性。

chatgpt训练了多少数据

chatgpt在训练时会利用大量的数据来学习语言知识和语言规律,从而提高其对语言的理解和生成能力。从数据规模、数据来源和数据预处理三个方面来详细说明chatgpt训练数据。

1. 数据规模

chatgpt训练数据规模庞大,其首次推出的版本GPT-1使用的是40GB的数据,而后续版本GPT-2使用的是1.5TB的数据。这些数据包括了来自各个领域的语言数据,如、新闻报道、小说、科技博客等,以及来自社交媒体平台、聊天记录等真实用户对话数据。这些来自不同领域和不同来源的语言数据贡献了丰富的知识和语言规律,有助于提高chatgpt的语言生成和理解能力。

2. 数据来源

chatgpt训练数据涵盖了语言数据来源的各个方面,如百科全书、小说、新闻报道、科技博客、论文等,这些数据来源涉及了不同领域、不同形式和不同风格的语言数据,从而促进了chatgpt学习不同的语言知识和语言规律。还有,chatgpt还使用了大量的聊天记录和社交媒体数据,这些真实用户的对话数据能够使chatgpt更好地理解人类语言,并生成更接近自然语言的文本。

3. 数据预处理

chatgpt的训练数据需要进行预处理才能适用于模型的训练。预处理的目的是去除不相关的信息,提取出有用的语言知识和规律,并且对语言数据进行转换和标注。具体而言,chatgpt的预处理包括文本清洗、分词、标注、截断、句子拆分等。例如,分词是一项关键的预处理任务,它能将文本转换成单独的词或短语,提取出语言数据中的有用信息。标注则能够识别句子的结构和语法规则,从而为chatgpt提供更准确的语言指导。这些预处理任务帮助chatgpt更好的学习语言知识和规律,从而生成更自然、更流畅的文本。

chatgpt有多少数据

总分总的结构是将一个主题或问题分为三个层次进行讲解,分别是总体概述、具体细节和再次总结。那么我将用总分总的结构来阐述一下chatgpt有多少数据。

总体概述,由OpenAI公司开发。它可以生成准确流畅的语言输出和对话,因此被广泛应用于自然语言处理、聊天机器人等领域。而chatgpt的数据量对于它的性能和效果有着重要的影响。

具体细节:根据官方的介绍,chatgpt模型使用了超过45TB的原始文本数据进行预训练,包括网页、电子书、新闻文章等多种类型的文本数据。这些数据来自于互联网上的各种来源,如Common Crawl以及一些公开的数据集。并且,chatgpt模型还使用了一些人工生成的对话数据来进一步提升它的对话生成能力。因此,chatgpt的数据量巨大,超过了许多其他自然语言处理模型的数据量。

再次总结:总之说一句,chatgpt的数据量非常巨大,超过了45TB,包含了大量的原始文本数据和人工生成的对话数据。这些数据对于chatgpt的性能和效果有着重要的影响,为它的出色表现提供了坚实的基础。

chatgpt训练数据

1. 数据来源:chatgpt训练数据可以来源于多个渠道,例如社交媒体、新闻文章、业内专家博客、聊天记录等等。这些数据来源广泛,可靠性和质量也不同,需要经过处理和筛选。

2. 数据数量:chatgpt训练数据需要够大才能保证模型的精度。大量的数据可以提高模型的泛化能力,帮助模型学习到更多的语言结构和语言表达方式。因此,chatgpt训练数据的数量应该越大越好。

3. 数据质量:除了数量,chatgpt训练数据的质量也非常重要。数据质量包括语言结构的正确性、语法的准确性以及数据的完整性等。如果数据质量不高,会影响模型的学习和效果。因此,在选择训练数据时,需要注意数据的来源、处理方法和验证方法等,以确保数据质量。

评论列表 (0)