要创建 ChatGPT 模型,需要执行以下步骤。

chatgpt怎么创建模型

要创建 ChatGPT 模型,需要执行以下步骤:

1. 安装 PyTorch 库,该库提供了 GPT 模型的 API。

2. 下载 GPT 模型的预训练权重,可以从 PyTorch Hub 下载。

3. 创建一个 `GPT2LMHeadModel` 模型对象,该对象是一个多层神经网络,其中包含一个 Transformer 编码器和一个线性输出层。

4. 通过加载预训练权重初始化模型参数。

5. 对输入文本进行预处理,例如,将其划分为 token 并将其转换为模型的输入格式。

6. 使用模型对输入进行推断,生成模型的输出。

7. 根据输出生成对话回应,并将其返回给用户。

这些步骤的具体实现可以参考 PyTorch 官方文档和示例代码。

利用chatgpt创建自己的模型

在自然语言处理领域,建立自己的模型通常需要大量的数据和计算资源,这对于普通研究人员或从事自然语言处理相关工作的开发者来说,是一个很大的挑战。但是现在,有一种新型的工具ChatGPT,可以帮助人们创建自己的模型,让自然语言处理更加简单,更加高效。

ChatGPT是一个自然语言处理的工具,基于开源项目GPT-2和GPT-3,旨在提供更便捷的自然语言处理服务,其借助GPT-3强大的语言生成和分析能力,在不需要庞大计算资源和大量数据的情况下,让使用者可以轻松创建自己的自然语言处理模型。

在使用ChatGPT时,首先需要在平台上注册账户,然后通过简单的设置,即可使用ChatGPT进行自然语言处理。ChatGPT可以进行多种自然语言处理任务,包括情感分析、文本分类、对话生成等,用户可以根据自己的需求,选择不同的任务类型,并在平台上训练自己的模型。

ChatGPT的使用非常简单,用户只需要上传自己的数据,选择模型类型,并在平台上进行训练即可。平台提供了可视化的训练过程,让用户可以直观地了解模型的训练情况和效果。训练完成后,用户可以使用API或SDK等方式接入ChatGPT,将自己的模型应用到自己的项目中。

ChatGPT的优点在于它不需要大量的训练数据和高性能的计算资源,就能够实现较高的自然语言处理效果。首先来说,平台提供了多种自定义选项,包括模型架构、训练参数、处理器类型等,让用户可以根据自己的需求进行模型定制。

总体而言,ChatGPT是一个非常有用的自然语言处理工具,它的出现使得创建自己的模型变得更加简单、高效和便捷。如果你是一名自然语言处理的学者或从事自然语言处理相关工作的开发者,那么建议你试试ChatGPT,相信它一定会给你带来惊喜。

怎么用chatgpt建模

ChatGPT是目前最先进的自然语言处理模型之一,它基于GPT-2和GPT-3开发而来,可以用于各种自然语言处理任务中。在这篇文章中,我们将向您介绍如何使用ChatGPT进行建模。

首先来说,您需要准备好一个能够支持Python编程语言的开发环境,例如Anaconda或者Jupyter Notebook等。接着,您需要安装PyTorch和Transformers两个Python库。您可以通过以下命令来安装它们:

`!pip install torch`

`!pip install transformers`

在使用ChatGPT进行建模之前,您需要准备好训练数据。这些数据应该是标准格式的文本数据,例如CSV或者JSON格式的文件。数据应该具有一定的规模和丰富性,以便于训练出更加准确的模型。

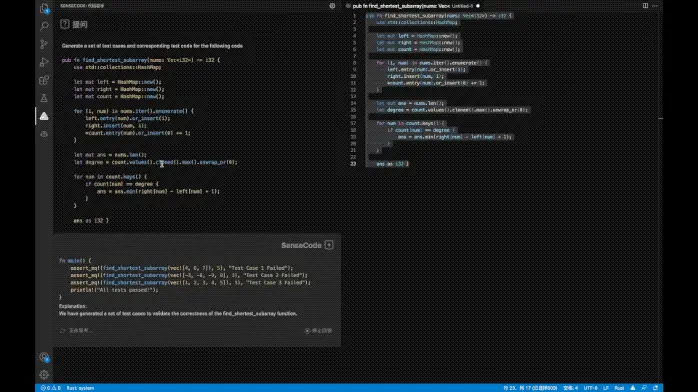

接下来,您需要利用Transformers库中的GPT2LMHeadModel类来建立一个基于ChatGPT的模型。该类是一个PyTorch模型,可以通过以下代码进行初始化和训练:

from transformers import GPT2LMHeadModel, GPT2Tokenizer tokenizer = GPT2Tokenizer.from_pretrained('gpt2') model = GPT2LMHeadModel.from_pretrained('gpt2', pad_token_id=tokenizer.eos_token_id)

在模型训练的过程中,您还需要选择一个适合的优化算法和损失函数。常用的优化算法有Adam和SGD等,而损失函数则通常选用交叉熵函数。您可以使用以下代码来定义优化算法和损失函数:

from transformers import AdamW optimizer = AdamW(model.parameters(), lr=1e-5) loss_function = nn.CrossEntropyLoss()

现在,您可以开始训练模型了。在进行模型训练之前,您需要将文本数据转换成模型可以接受的格式。您可以使用GPT2Tokenizer来将文本数据进行编码:

input_ids = tokenizer.encode('这是一段文本数据', return_tensors='pt')

接下来,您可以开始训练模型。在训练过程中,您需要利用PyTorch的自动微分机制来计算梯度并更新参数:

outputs = model(input_ids) loss = loss_function(outputs.logits.view(-1, model.config.vocab_size), input_ids.view(-1)) loss.backward() optimizer.step()

训练出来的模型,可以用于生成文本数据或者进行对话生成。您可以使用以下代码来生成文本数据:

generated = model.generate(input_ids=input_ids, max_length=50, do_sample=True)

decoded = tokenizer.decode(generated[0], skip_special_tokens=True)

print(decoded)

首先来说,您还需要对训练出来的模型进行评估。您可以使用各种自然语言处理指标来评价模型的性能,例如准确率、召回率、F1值等。同时,您还可以使用人工评价的方法来评估模型的生成质量。

总体来说,使用ChatGPT进行建模需要准备好自然语言处理训练数据、安装必要的Python库和利用PyTorch和Transformers建立模型、选择优化算法和损失函数、训练模型、生成文本数据和对模型进行评估。希望这篇文章对您有所帮助,让您能够更好地使用ChatGPT进行自然语言处理建模。

快手建模怎么手工建模

1. 建模前准备:手工建模需要具备良好的基础素描能力和三维空间观察能力,建议先学习相关基础知识。同时,需要准备相关工具,如铅笔、橡皮、尺子、量角器、剪刀等。

2. 手工建模过程:首先根据设计要求,选定合适的比例尺和比例模型。然后根据设计图纸,利用铅笔和尺子在纸板或泡沫板上勾画出模型的轮廓,根据轮廓逐步削减和雕刻,最终得到模型的基本形状。在此基础上,可以使用刀具和模具等工具进行修整和细节处理,使模型更加精细和真实。

3. 后期处理:手工建模完成后,需要进行表面处理和涂装。一般先用沙纸打磨表面,去除毛刺和粗糙的部分,然后用喷漆或彩笔等进行涂装和细节处理。涂装时需要注意色彩搭配和均匀涂抹,最终得到一个高度还原设计要求的手工模型。

评论列表 (0)