Chatbot是基于人工智能的自动聊天机器人,能够模仿人的语言和行为,与用户进行自然的对话。而在最近的几年中,在自然语言处理技术的帮助下,使得聊天机器人的交互性能有了质的飞跃。作为一种新型的对话生成技术,GPT已经被广泛应用于聊天机器人、问答系统、机器翻译等领域。

chatgpt参数量

Chatbot是基于人工智能的自动聊天机器人,能够模仿人的语言和行为,与用户进行自然的对话。而在最近的几年中,在自然语言处理技术的帮助下,使得聊天机器人的交互性能有了质的飞跃。作为一种新型的对话生成技术,GPT已经被广泛应用于聊天机器人、问答系统、机器翻译等领域。

。该模型采用了无监督的预训练方法,可以用大规模的文本数据去训练。在预训练后,该模型可以生成自然语言文本,也就是说,它可以模拟人类的语言生成能力。在聊天机器人中,从而实现更加自然、流畅的对话。

Chatbot与GPT模型的结合,可以带来许多优点。比如,可以使Chatbot更加智能化,能够根据用户的提问进行响应,并且在对话的过程中不断学习优化。另外,GPT模型可以使Chatbot产生更加真实的回答,从而使用户的体验更加自然。首先来说,GPT模型的参数量很大,可以训练出更加复杂的模型,从而在语言生成方面具有更高的准确性和表现力。

另外还有,GPT模型也存在一些缺陷,例如生成的文本中可能存在歧义或语法错误等问题。当然,模型的参数量较大,需要消耗大量的计算资源和存储空间。因此,开发人员需要在保证模型质量的同时,尽量控制模型的规模,以便在实际应用中更加高效地运行。

总体来看,Chatbot与GPT模型结合,可以带来更加自然、流畅的对话体验。在使用时,需要权衡模型的质量和参数量,以便达到最佳的性能表现。未来,随着技术的不断发展,Chatbot与GPT模型的结合将会呈现出更加广阔的应用前景。

chatgpt模型参数量

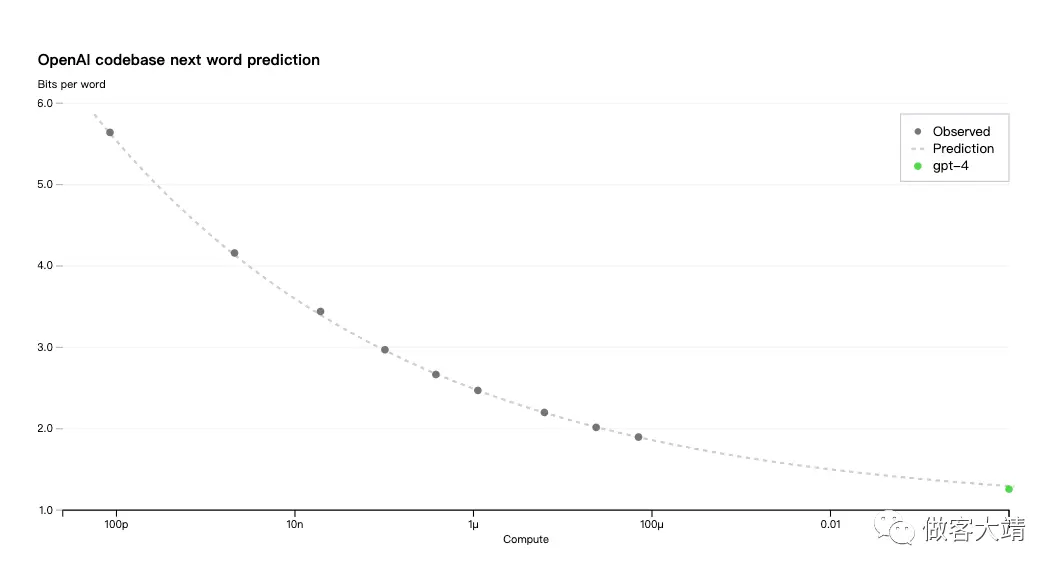

在自然语言处理(Natural Language Processing, NLP)中,其目的是一个给定序列的下一个单词或字符。GPT(Generative Pre-trained Transformer)是OpenAI公司开发的一种生成式预训练转换器,能够自动产生与输入序列密切相关的文本。它已成为自然语言处理领域最重要的技术之一,因此它的参数量成为了一个热门话题。

GPT模型主要是基于transformer架构来构建的,与其他自然语言处理技术相比,其参数量很大。在GPT-2版本中,参数量达到了1.5亿,并且GPT-3版本中参数量约为13亿。这些参数量庞大的模型是为了更好地捕捉输入序列的上下文,从而使其能够生成相应的输出。

然后,这种巨大的参数量是需要消耗大量计算资源的。在训练过程中,更大的模型需要更多的计算资源。为了训练GPT-3模型,OpenAI公司采用了数百个图形处理器(GPU),并且训练了数月之久。

对于大多数企业和科研团队,他们可能无法负担这样高的成本。幸运的是,由于GPT模型的开源性质,许多预训练模型可以在云端GPU上进行微调,从而可以方便地使用这些模型,而无需拥有一个高昂的GPU集群。

总之说一句,GPT模型的参数量越大,生成的文本质量越高。但是,这种巨大的参数量也需要大量的计算资源。对于大多数用户,使用预训练的GPT模型来生成自然语言文本是非常方便和实用的。

chatgpt参数数量

主体:chatgpt参数数量是指GPT模型中可调整的可训练参数的数量。具体来说,这些参数是在训练过程中通过不断优化来调整的,以使模型能够更好地处理输入,并生成更准确的输出结果。

分论1:chatgpt参数数量的影响因素

chatgpt参数数量的影响因素包括模型的深度、宽度以及其他的架构设计相关的因素。具体来说,参数数量与模型的深度和宽度呈正相关关系,即模型越深、宽,其参数数量也会随之增加。

分论2:chatgpt参数数量的应用领域

chatgpt参数数量的应用领域非常广泛。例如,在自然语言处理领域,chatgpt参数数量的多少将直接影响到模型的语言生成能力、对话处理能力等方面。在计算机视觉领域,chatgpt参数数量的多寡也将直接影响到模型的视觉识别和图像处理能力。

总结:chatgpt参数数量是GPT模型中可训练的可调整参数的数量。其数量受到模型深度、宽度等架构设计因素的影响。chatgpt参数数量在自然语言处理、计算机视觉等领域具有广泛的应用价值。

chatgpt参数

ChatGPT是一种基于GPT-2模型的聊天机器人,它可以进行自然语言交互和回复。ChatGPT具有多个参数,其中一些是:

1. model_size: 指定GPT-2模型的大小,可选择的大小有小、中、大和超大。

2. num_layers: 指定GPT-2模型中的隐藏层数,该参数越大,模型的复杂度越高。

3. num_heads: 指定每个多头自注意力机制中的头数,该参数越大,模型的自适应能力越强。

4. max_sequence_length: 指定模型能够处理的最大输入序列长度,该参数通常取决于所使用的硬件资源。

5. temperature: 指定模型生成文本时的温度,用于控制生成文本的多样性,较高的温度会生成更多的随机文本。

6. top_k: 指定模型在生成文本时保留概率最高的前k个词,用于提高生成文本的质量和可读性。

7. top_p: 指定模型在生成文本时保留累积概率大于等于p的词,用于生成较为连贯的文本。

这些参数可以根据不同的应用场景进行调整,以获得更好的性能和效果。例如,对于生成较为正式的文本,可以采用较小的temperature和较高的top_k和top_p值,以确保生成文本具有一定的连贯性和可读性;而对于生成更加随机和趣味性的文本,则可以选择较高的temperature值和较小的top_k和top_p值,以生成更加有趣和多样的文本。

评论列表 (0)