综上所述,ChatGPT模型是一种大参数模型。大参数模型是指具有大量参数的机器学习模型,其优点是可以更好地拟合输入数据,从而提高精度和模型性能。

chatgpt模型大参数模型

总体来说,ChatGPT模型是一种大参数模型。大参数模型是指具有大量参数的机器学习模型,其优点是可以更好地拟合输入数据,从而提高精度和模型性能。

ChatGPT模型是由OpenAI开发的基于transformer架构的语言生成器。该模型使用了大量的参数,包括语言特征嵌入、语言生成层、自注意力机制等。这些参数能够让模型更准确地理解输入的自然语言,从而生成更加符合语境和语法的对话。

ChatGPT模型的总分总结构可以如下表示:

总体而言,ChatGPT模型是一种大参数模型,其优点在于可以更好地拟合输入数据。在ChatGPT模型中,使用了大量参数,包括语言特征嵌入、语言生成层、自注意力机制等。这些参数能够让模型更准确地理解输入的自然语言,从而生成更加符合语境和语法的对话。因此ChatGPT模型在自然语言生成方面有着广泛的应用潜力。

chatgpt模型参数量

在自然语言处理(Natural Language Processing, NLP)中,其目的是一个给定序列的下一个单词或字符。GPT(Generative Pre-trained Transformer)是OpenAI公司开发的一种生成式预训练转换器,能够自动产生与输入序列密切相关的文本。它已成为自然语言处理领域最重要的技术之一,因此它的参数量成为了一个热门话题。

GPT模型主要是基于transformer架构来构建的,与其他自然语言处理技术相比,其参数量很大。在GPT-2版本中,参数量达到了1.5亿,并且GPT-3版本中参数量约为13亿。这些参数量庞大的模型是为了更好地捕捉输入序列的上下文,从而使其能够生成相应的输出。

与此同时,这种巨大的参数量是需要消耗大量计算资源的。在训练过程中,更大的模型需要更多的计算资源。为了训练GPT-3模型,OpenAI公司采用了数百个图形处理器(GPU),并且训练了数月之久。

对于大多数企业和科研团队,他们可能无法负担这样高的成本。幸运的是,由于GPT模型的开源性质,许多预训练模型可以在云端GPU上进行微调,从而可以方便地使用这些模型,而无需拥有一个高昂的GPU集群。

总之,GPT模型的参数量越大,生成的文本质量越高。还有一点,这种巨大的参数量也需要大量的计算资源。对于大多数用户,使用预训练的GPT模型来生成自然语言文本是非常方便和实用的。

chatgpt模型下载

近年来,人工智能技术的快速进步为各个领域带来了新的发展机遇。其中,自然语言处理技术的发展,为人们的语言沟通带来了更加智能化和自然化的感受。而ChatGPT模型的出现,则为自然语言处理技术的发展注入了新的动力。

ChatGPT模型是一种基于大规模预训练的通用对话生成模型。它是由OpenAI开发的一种人工智能算法,采用了GPT技术的改进版本。ChatGPT模型的核心思想是通过大量的对话训练数据,来学习和理解人类语言的奥秘和潜在规律,最终实现与人类的自然语言交互。

ChatGPT模型的优点在于,它可以适应不同类型的对话场景,包括问答、客服、闲聊等。第一,与其他对话生成模型相比,ChatGPT模型具有更加自然、流畅、准确的语言生成能力。这使得ChatGPT模型在实际应用场景中具有广泛的应用前景,例如智能客服、智能问答、语音交互等。

如果你想使用ChatGPT模型进行开发和研究,可以考虑从以下方面入手:

1. 下载预训练模型

ChatGPT模型的预训练模型已经在GitHub上公开发布,你可以直接下载使用。这些预训练模型分别包括GPT-2和GPT-3等不同版本,可以根据你的需求选择合适的版本进行下载和使用。

2. 学习模型训练方法

如果你想深入了解ChatGPT模型的训练方法和技术细节,可以通过学习相关的论文和资料来进行研究和实践。第二,也可以通过开源社区等方式,与其他开发者和研究者进行交流和合作。

3. 运用模型进行实际应用

一旦掌握了ChatGPT模型的使用技能,你就可以通过将其应用到实际场景中,来实现更加智能化和自然化的语言交互。例如,你可以将ChatGPT模型应用到智能客服、智能问答、语音交互等场景中,为用户提供更加便捷、高效和舒适的服务体验。

综上所述,ChatGPT模型的出现和发展,为自然语言处理技术的进步和发展注入了新的动力。如果你想探索和应用这一技术,可以从预训练模型、学习模型训练方法和运用模型进行实际应用等方面入手。相信在未来的日子里,ChatGPT模型将为人们的语言交互带来更加智能化和自然化的体验。

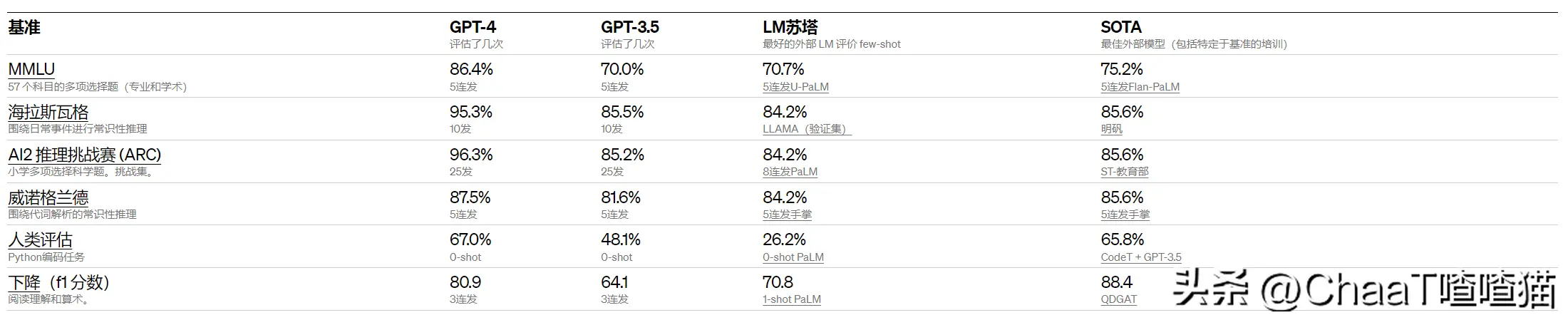

chatgpt模型参数

由OpenAI团队开发。GPT模型能够自动学习语言的规律和特征,并且生类可读的连续文本。它可以用于文本生成、机器翻译、问答系统等多个自然语言处理任务。本文将讨论GPT模型的参数及其影响因素。

GPT模型的参数包括模型的层数、每层的神经元数量、隐藏层的维度、头数、注意力机制等。这些参数的设置决定了模型的能力和效果。

第一,层数是GPT模型的重要参数之一,一般而言,层数越多,能够处理的信息就越多,但计算量也会增加。在实际应用中需要根据不同的场景和应用情况来选择模型的层数。

第二,每层神经元数量也是一个重要的参数,它决定了模型的复杂度和学习能力。通常情况下,较大的神经元数量能够提高模型的准确度,但会消耗更多的计算资源。

另外,隐藏层的维度也是一个需要调整的参数。隐藏层的维度越高,模型就能学习到更多的语义信息。但第三,高维度的隐藏层也需要更多的计算资源来进行训练和推理。

头数也是GPT模型需要确定的一个参数。头数决定了不同位置之间的相关性。较大的头数能够增加模型的准确度,但会消耗更多的计算资源。

除此之外,注意力机制也是GPT模型的核心组成部分之一。通过注意力机制,模型能够将不同位置的信息结合起来,从而生成连续的文本。不同的注意力机制也会影响模型的效果和速度。

总之,GPT模型的参数设置是非常重要的。需要根据实际应用情况进行调整,以达到最佳的效果。第四,也需要考虑计算资源的限制,选择适当的参数组合。

评论列表 (0)